Transformer(上) 背景介绍

论文地址:https://arxiv.org/pdf/1810.04805.pdf

一,Transformer相关背景

- 2018年10月,Google发出一篇论文《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》, BERT模型横空出世, 并横扫NLP领域11项任务的最佳成绩!

- 而在BERT中发挥重要作用的结构就是Transformer, 之后又相继出现XLNET,roBERT等模型击败了BERT,但是他们的核心没有变,仍然是:Transformer.

二,Transformer的优势

Transformer能够利用分布式GPU进行并训练,提升模型训练效果。

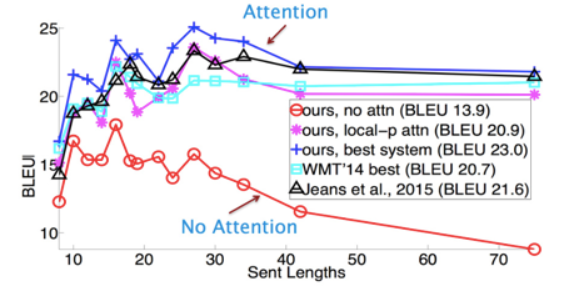

在分析预测更长的文本时, 捕捉间隔较长的语义关联效果更好。

下面为评测比较图

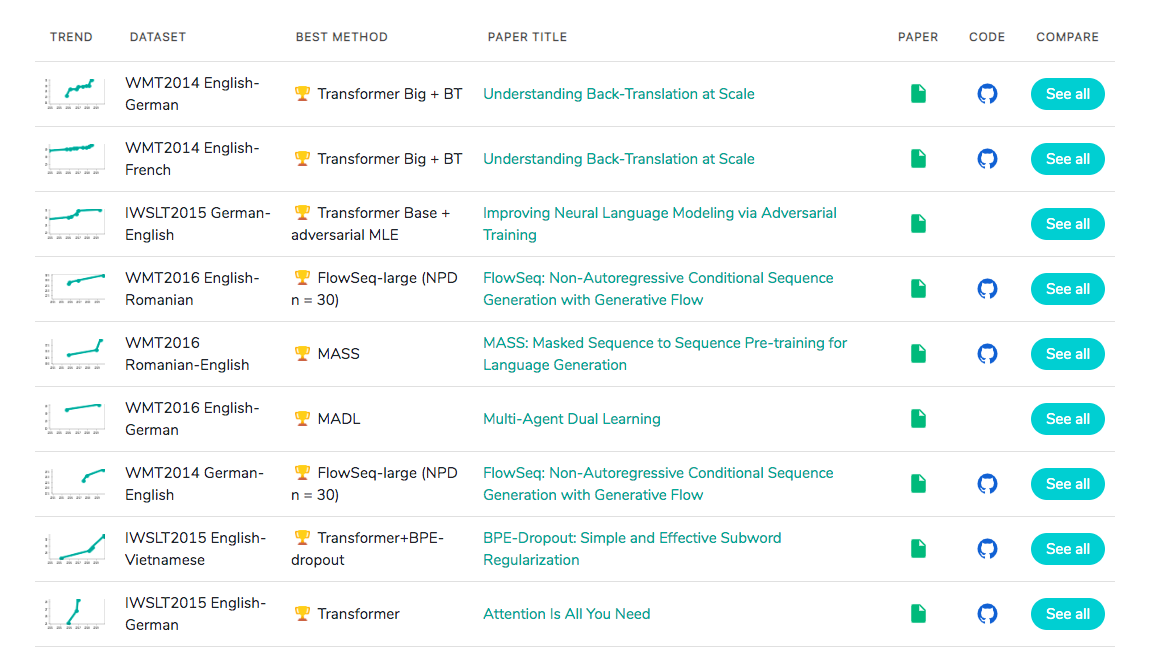

三,Transformer的当前市场情况

其基本上可以看作是工业界的风向标, 市场空间自然不必多说!