- 每个单词被嵌入到大小为512的向量中

- 编码器接受一个向量列表作为输入,首先将这些向量传到自注意力层,然后传递到前馈神经网络

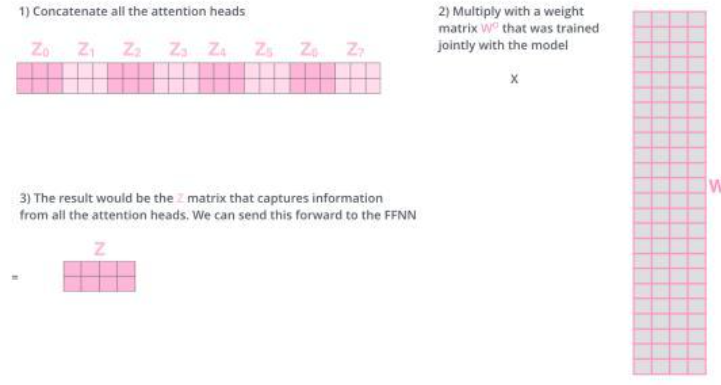

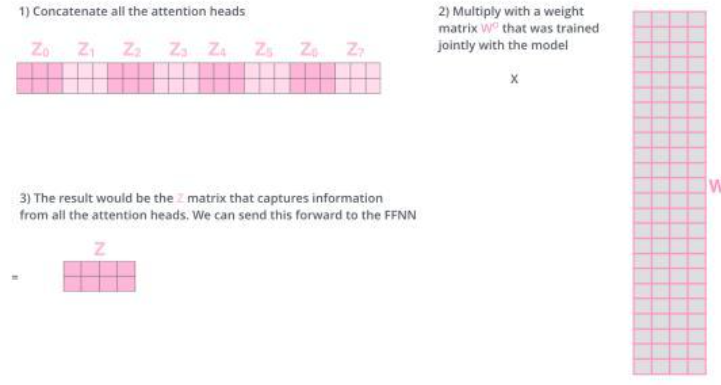

- 多头注意力下没个头维护不同的qkv,从而得到不同的qkv,所以最终将的到八个不同的z矩阵

- 前馈全连接层需要的是一个单一的矩阵而不是八个矩阵,所以要想办法对这八个矩阵进行压缩

- 所以这里将八个矩阵拼接,并将它们乘以一个另外的权重矩阵wo,如图

人工智能网站大全

人工智能网站大全

BERT,Transformer模型架构与详解

BERT,Transformer模型架构与详解